crontab执行耗时时间长

时间:2023-05-24 来源:网络 人气:

最近有一位朋友在使用crontab时发现它执行的时间非常长,于是他向我请教该如何优化。这让我想到了很多关于crontab的问题,因此我决定写一篇文章来分享我的经验和建议。本文将详细介绍crontab的优化方法,以及如何避免一些常见的错误。

1.crontab是什么?

首先,我们需要了解什么是crontab。简单来说,crontab是一个可以在Linux系统上定时执行某个任务的工具。用户可以通过编辑一个特殊的文件来指定任务的执行时间和命令。这个文件通常被称为“crontab文件”,而每个用户都可以拥有自己的crontab文件。

2.crontab执行耗时时间长的原因

当我们使用crontab时,可能会遇到执行时间过长的问题。这种情况通常有以下几个原因:

(1)任务本身执行时间过长

当我们指定一个任务,并且它需要大量的计算资源或者IO操作时,它可能会执行很长时间。

(2)任务之间存在依赖关系

如果我们指定了多个任务,并且它们之间存在依赖关系,那么其中一个任务失败可能会导致其他任务无法执行。

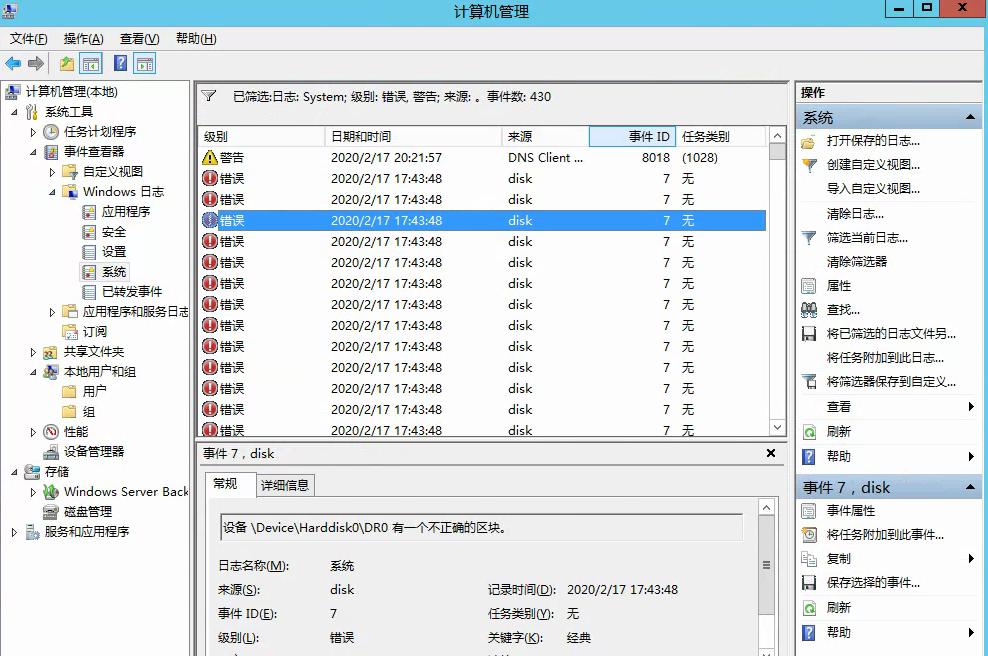

(3)系统资源不足

如果我们的系统资源不足,例如CPU、内存或磁盘空间,那么任务执行的时间可能会很长。

3.如何优化crontab执行时间

为了解决crontab执行时间过长的问题,我们可以采取以下措施:

(1)优化任务本身

如果我们的任务需要大量计算或IO操作,我们可以尝试优化它。例如,我们可以使用缓存来减少IO操作次数,或者使用并行处理来加速计算。

(2)避免任务之间的依赖关系

如果我们指定了多个任务,并且它们之间存在依赖关系,那么我们应该确保依赖关系正确,并且在任何情况下都能够正确执行。我们还可以尝试将依赖关系转移到脚本中,以便更好地控制它们。

(3)增加系统资源

如果我们的系统资源不足,那么我们可以考虑增加系统资源。例如,我们可以添加更多的内存或CPU核心,并且在运行任务时关闭其他不必要的进程。

(4)避免重复执行

有时候我们可能会指定一个任务在短时间内重复执行。这种情况可能会导致任务之间发生冲突,并且影响整个系统的性能。因此,我们应该尽可能避免这种情况发生。

4.一个实际案例

为了更好地理解如何优化crontab执行时间,我们可以看一个实际案例。假设我们需要每天备份MySQL数据库,并将备份文件上传到云存储服务中。我们可以使用以下脚本:

#!/bin/bash

BACKUP_DIR=/var/backups/mysql

S3_BUCKET=s3://my-bucket

#Createbackupdirectoryifnotexists

mkdir-p$BACKUP_DIR

#BackupMySQLdatabase

mysqldump-uroot-pPASSWORDmy_database>$BACKUP_DIR/my_database.sql

#Compressbackupfile

gzip$BACKUP_DIR/my_database.sql

#UploadbackupfiletoS3bucket

awss3cp$BACKUP_DIR/my_database.sql.gz$S3_BUCKET

这个脚本非常简单,它会备份MySQL数据库并将备份文件上传到S3桶中。但是,如果我们将其添加到crontab中并执行,它可能会执行很长时间,特别是当数据库很大时。

为了优化这个脚本,我们可以采取以下措施:

(1)优化MySQL备份

我们可以使用mysqldump命令的--single-transaction选项来避免在备份期间锁定表。这样可以减少备份所需的时间。

(2)在上传之前压缩文件

我们可以在上传之前压缩备份文件。这样可以减少上传所需的时间。

(3)使用更快的云存储服务

如果我们的云存储服务速度很慢,那么我们可以考虑使用更快的服务。例如,我们可以使用AWSS3的多部分上传功能来加速上传。

5.总结

在本文中,我们介绍了crontab执行耗时时间长的原因,并提供了一些优化建议。要避免crontab执行时间过长,我们应该尽可能优化任务本身、避免任务之间的依赖关系、增加系统资源,并避免重复执行。当然,在实际情况下,我们可能需要根据具体情况采取不同的措施。

tokenpocket最新版:https://cjge-manuscriptcentral.com/software/2410.html

相关推荐

教程资讯

教程资讯排行

系统教程

- 1 安卓8系统wifi断流,安卓8系统WiFi断流问题解析与解决攻略

- 2 安卓系统8.1oppo,性能升级与用户体验革新

- 3 安卓系统地震预警在哪,地震预警信息在安卓系统中的生成过程概述

- 4 安卓系统更新 文件路径,安卓系统更新文件路径解析与更新概述

- 5 安卓系统窗口怎么调,只需将`subtitle`变量的值替换为相应的字符串即可。

- 6 安卓系统可以定位,安卓系统定位功能解析与应用

- 7 安卓插件调用系统音效,Android插件轻松调用系统音效功能解析

- 8 安卓怎么装win系统,教你如何安装Windows系统

- 9 钉钉3安卓系统,功能升级与用户体验优化全面解析

- 10 安卓平台windows系统下载,轻松实现跨平台操作

-

标签arclist报错:指定属性 typeid 的栏目ID不存在。